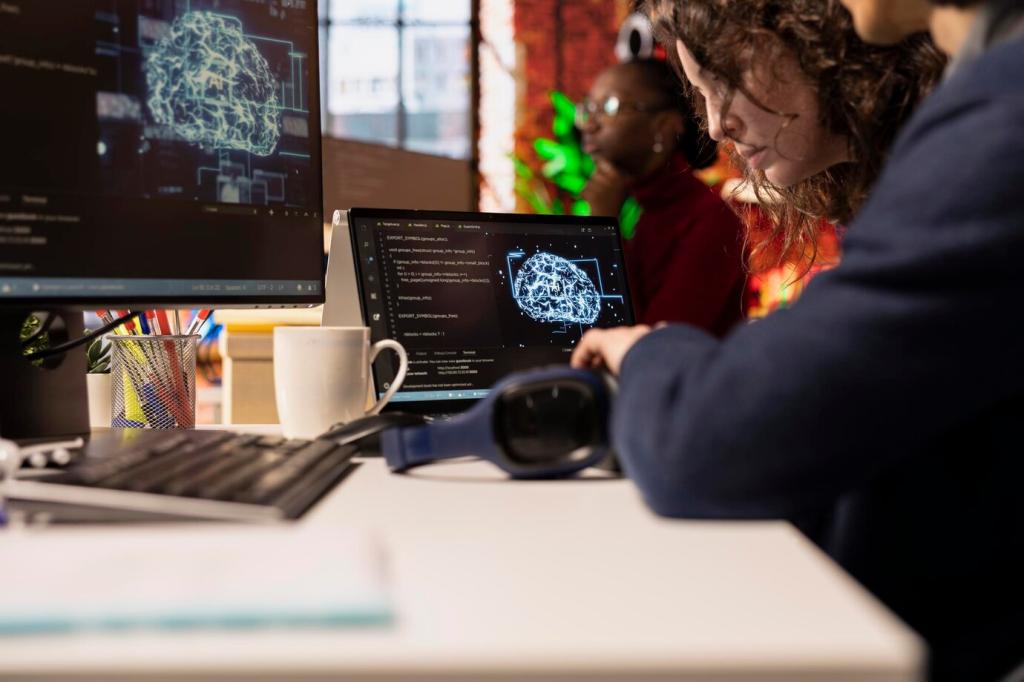

Rechtlicher Rahmen: DSGVO, ePrivacy und Hochschulpolitik

Zweckbindung, Datenminimierung und Betroffenenrechte bilden den Kern. Für das Online-Lernen bedeutet das: klare Zwecke definieren, nur notwendige Daten erheben und jederzeit Auskunft, Berichtigung sowie Löschung ermöglichen, ohne die Studienleistung zu beeinträchtigen.

Rechtlicher Rahmen: DSGVO, ePrivacy und Hochschulpolitik

Nicht jede KI-Analyse darf auf Zwang beruhen. Wo Alternativen möglich sind, sollte echte Wahlfreiheit bestehen. Fakultäten können parallel datensparsame Wege anbieten, damit niemand zwischen guter Note und Privatsphäre entscheiden muss.